Par Claude Serfati

Par Claude Serfati

Cet article, consacré à la pénétration de l’intelligence artificielle (IA) dans le domaine militaire comporte deux parties distinctes. La première partie décrit les effets des transformations radicales des technologies sur les équipements militaires et les stratégies de défense. La seconde partie propose un focus sur la France, puissance militaire de premier rang mondial. On peut craindre que les plans gouvernementaux dédiés à l’IA amplifient la centralité du militaire dans les politiques publiques de la France.

De façon très approximative, les cabinets de consultants estiment en 2023 le marché mondial de l’IA à des fins militaires à 8 milliards de dollars et le marché mondial commercial à environ 800 milliards de dollars. Ces ordres de grandeur indiquent où se situent les dynamiques économiques, mais ils ne disent rien de l’importance majeure de l’IA dans les transformations des nouvelles formes de conflit. Dès la fin des années 2010 – la Chine en 2017, les Etats-Unis en 2018, la France en 2019 – les militaires des grandes puissances mondiales ont sérieusement pris en compte l’IA. Cette évolution s’est inscrite dans le contexte de la fin des années 2000 qui fut marqué par un durcissement de la concurrence économique et une amplification des rivalités géopolitiques. C’est ce que j’appelle le ‘moment 2008’, cette convergence unique de temporalités d’une crise financière transformée en longue dépression, de la dégradation climatique accélérée, de déclin des Etats-Unis et de l’irruption des peuples (les ‘printemps arabes’).

L’IA produit des ruptures majeures

Il n’existe pas de définition unique de l’intelligence artificielle (IA) et la raison pourrait être due au moins autant à la difficulté de comprendre ses contours disciplinaires qu’à une campagne médiatique utilisée pour en justifier toutes les conséquences, y compris celles qui sont néfastes pour la société [1]. Pour les économistes de l’innovation, l’IA constitue une technologie de portée générale (TPG) qui, comme le moteur à vapeur au début de la révolution industrielle, l’électricité à la fin du dix-neuvième siècle et l’informatique après la seconde guerre mondiale, se diffuse dans tous les secteurs de l’économie et de la société. Mais l’histoire ne se répète jamais de la même façon. L’IA se distingue radicalement de toutes les autres TPG car ses développements se situent d’emblée à l’échelle internationale et ils sont donc un enjeu de rivalités économiques et géopolitiques entre quelques grandes puissances.

De plus, à rebours de ce que permettrait leur usage socialement maîtrisé afin de satisfaire les besoins de l’humanité, les technologies qui reposent sur l’IA transforment simultanément les données en une source d’accumulation de profits, elles renforcent le pouvoir sécuritaire des Etats et elles introduisent de nouvelles formes de guerre grâce à leur utilisation par les militaires. L’IA réduit un peu plus les différences entre les dimensions militaires et civiles des conflits au sein de l’agenda de sécurité nationale des grandes puissances. En somme, elle offre des potentialités d’utilisation contre des êtres humains dans tous les domaines de leur vie en société en tant qu’ils sont salariés, citoyens et ‘civils’ menacés par les guerres.

Cet article n’aborde donc qu’une dimension de l’ubiquité des pouvoirs de l’IA. De plus, il laisse de côté les puissants effets de régénération du ‘complexe militaro-industriel’ américain opérés par l’importance croissante des GAFAM dans l’industrie de défense, un processus aujourd’hui largement sous-estimé [2].

L’intégration de l’IA dans les doctrines et les équipements militaires marque une étape supplémentaire dans la longue histoire de l’utilisation des technologies à des fins de destruction. L’émergence de systèmes d’armes autonomes est ainsi souvent décrite comme une troisième révolution militaire, après l’invention de la poudre et les armes nucléaires. En effet, elle offre aux militaires de nombreuses opportunités qui se situent sur quatre plans principaux. D’abord, elle améliore les performances des systèmes d’armes existants et rend plus fiables certaines tâches accomplies par les soldats. Les technologies d’interface cerveau-ordinateur, utilisées dans les hôpitaux pour régénérer ou restaurer des fonctions altérées sont déjà utilisées pour des besoins militaires ou de sécurité nationale, soit pour augmenter les capacités physiques des soldats, soit pour des objectifs de pacification, d’interrogation ou de torture (par induction d’une douleur sensorielle sans blessure physique) [3].

De plus, grâce à l’IA, de nombreuses fonctions telles que les activités de renseignement, et de surveillance, de logistique, les cyberopérations, les opérations de commandement et de contrôle peuvent ou pourront prochainement être centralisée dans une source unique [4] (voir encadré ci-dessous).

___________

‘Frappes chirurgicales’ et ‘assassinats ciblés’: le grand mensonge

Ainsi qu’un militaire israélien l’a déclaré au magazine d’investigation israélien +972, l’utilisation de l’IA permet de générer 100 nouvelles cibles par jour contre 50 par an dans le passé. Et l’infox fait croire, comme lors des prétendues ‘frappes chirurgicales’ contre l’Irak en 2003, à une précision des objectifs ciblés qui, selon ses responsables, fait de l’armée israélienne «la plus humaine du monde». Or, son porte-parole a déclaré que les objectifs des bombardements à Gaza, «ne sont pas leur précision, mais l’ampleur du dommage créé» [5]. En somme, l’«Intensification algorithmique des destructions» [6] résulte de la combinaison de décisions prises par les militaires et des faiblesses de l’apprentissage machine, car les militaires ne peuvent alimenter les immenses besoins en données exigées par ces machines.

___________

Ensuite, l’IA peut être associée à d’autres technologies émergentes telles que l’informatique quantique, l’impression 3D ou encore les missiles hypersoniques qui volent à plus de 6000 km à l’heure et à 30 000 mètres de hauteur. Les modèles actuellement en développement sont lancés à partir de missiles balistiques qui peuvent eux-mêmes atteindre une vitesse de 25 000 km/h. L’étape en cours, celle de l’alliance de l’IA et du nucléaire, est âprement discutée par les spécialistes dont certains s’inquiètent: ‘nous sommes proches d’un moment Oppenheimer’. En effet, les Etats-Unis disposent d’un bombardier (le B-21) porteur d’armes nucléaires qui est capable d’exécuter des missions sans équipage et les Russes mettent au point un véhicule sous-marin sans équipage destiné à des frappes nucléaires de représailles [7]. Ces réalités pèsent beaucoup plus lourd que l’engagement des pays à ‘maintenir un humain dans la boucle’ et un contrôle politique permanent sur les armes nucléaires souhaité par les Nations Unies ainsi que la déclaration faite en février 2023 au sommet de La Haye par 57 pays (mais refusée par la Russie et Israël) en faveur d’un ‘usage responsable’ de l’IA sur le champ de bataille. De son côté, le gouvernement français a fait pression pour que le militaire soit exclu de l’Artificial Intelligence Act européen [8].

Enfin, et c’est un des objectifs principaux, certains types d’armes créés par l’IA intègrent une prise de décision autonome du système d’armes[9]. Une avancée majeure dans ce domaine est la création de Système d’armes létales autonomes (SALA) qui agissent au sol (les ‘robots tueurs’), dans les airs (les drones) et en mer (par exemple un navire chasseur de mines qui les détecte et les détruit). Ce sont des systèmes d’armes qui, une fois qu’ils sont activés, sélectionnent et visent des cibles sans intervention d’un opérateur [10]. Ces armes, qui disposent de fonctions joliment qualifiées de ‘tire et oublie’ (fire and forget), présentent plusieurs caractéristiques: la capacité à tuer, la capacité de fonctionner sans avoir besoin de l’intervention ou d’un contrôle humain, la capacité d’apprentissage par des interactions avec l’environnement qui leur permettent d’élargir leurs fonctionnalités et enfin l’impossibilité d’interrompre une opération une fois qu’elle a été lancée [11]. L’IA – par le truchement de l’apprentissage machine – décuple leurs potentialités dévastatrices, car les algorithmes qui sont intégrés produisent des résultats en partie non maîtrisés, une forme «d’imprévisibilité intrinsèque» (imprevisibility by design) sur la décision et le moment d’attaquer, ainsi que sur les conséquences qui en résultent [12]. En sorte qu’une bataille entre des systèmes autonomes ennemis pourrait dégénérer avant que l’intervention d’un militaire puisse empêcher la catastrophe [13]. D’autant plus que le ministère de la Défense des Etats-Unis est favorable à un système décentralisé qui augmente la distance entre l’objet (l’arme) et le sujet (l’opérateur) [14]. Le risque de perte de contrôle humain sur les armes semble assumé: le Pentagone réalise des tests afin de limiter au maximum l’intervention humaine dans les procédures de décision de haut niveau des armes qui utilisent l’IA [15]. Il faut ajouter que la large diffusion des recherches en IA dans des dizaines de pays facilite la prolifération des systèmes d’armes autonomes et augmente donc les risques d’un engrenage incontrôlé et de leur utilisation ‘préventive’ aux conséquences fatales [16].

France: un tropisme militaire porteur de déclin

Deux documents ont défini la stratégie gouvernementale dans le domaine de l’IA. En mars 2018, le rapport remis par Cédric Villani, «Donner un sens à l’intelligence artificielle, pour une stratégie nationale et européenne», fut élaboré à partir de l’audition de 420 experts. Son auteur rappelle: «Aujourd’hui, cependant, l’écrasante majorité des transferts circule du monde civil vers le monde militaire. C’est d’autant plus vrai dans le domaine de l’intelligence artificielle (IA)» [17]. Le même constat est fait par un responsable de la DGA (Direction générale de l’armement), le bras industriel du ministère de la Défense qui constate que le «déplacement vers le civil du centre de gravité du développement des technologies, en particulier numériques, nécessite d’amplifier une stratégie visant à améliorer leur détection puis leur captation au profit des finalités de l’innovation de défense» [18]. Le rapport publié par le ministère de la Défense en 2019, qui constitue l’autre document majeur en matière d’IA, constate également qu’un point commun des stratégies nationales c’est que «[l]es briques technologiques doivent ainsi diffuser […] du domaine civil au militaire» [19].

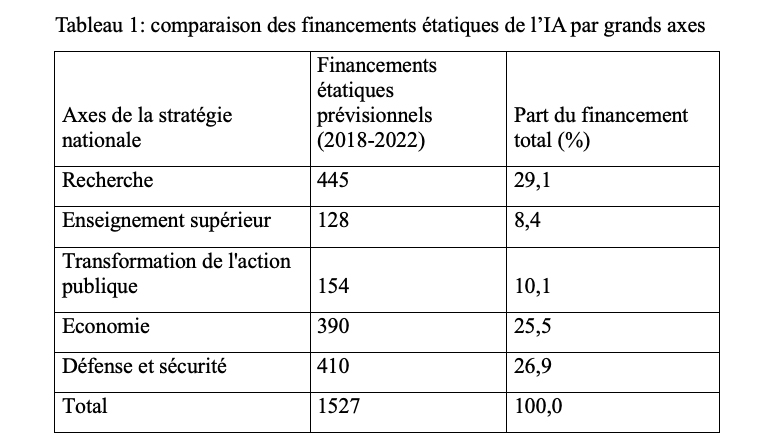

Voilà pour les déclarations. La réalité est tout autre et l’emprise militaire sur l’activité d’innovation se poursuit. Comme l’indique le tableau 1, dans la phase initiale (2018-2022) des mesures gouvernementales, la Défense a reçu presque autant de financement IA que la Recherche et plus que l’ensemble de l’‘économie’ française. Autrement dit, la Défense (qui pèse environ 2% du PIB) a reçu autant que tout le reste de l’industrie et des services.

Source: auteur, à partir des données de la Cour des Comptes (2023)

Cette surreprésentation du militaire va même être amplifiée. Le plan France 2030 prévoit d’accorder 2,2 milliards d’euros à l’investissement dans l’IA afin de soutenir la formation, favoriser la diffusion des technologies de l’IA et cibler quelques domaines prioritaires. Or, ce montant est à peine supérieur à celui affecté par la loi de programmation militaire 2024-2030 à l’IA de défense (2 milliards d’euros)[20]. Le gouvernement a également créé en mai 2024 l’agence ministérielle pour l’intelligence artificielle de défense.

A quoi vont servir ces 2 milliards d’euros ‘militaires’ consacrés à l’IA? Pour l’essentiel, à réaliser ce que la DGA appelle ‘une captation d’innovation’ [21] afin d’adapter les recherches menées dans les labos publics et privés civils aux besoins opérationnels, faire progresser l’autonomie décisionnelle des robots, concevoir les cockpits du futur, etc. «En effet, le secteur de la défense utilise des données issues de capteurs militaires spécifiques (radars, sonars, systèmes optroniques, équipements de guerre électronique) auxquels le secteur civil a peu accès» [22]. Le mythe du rôle moteur de la recherche militaire s’estompe un peu plus.

La défense n’est pas seulement privilégiée dans l’affectation des crédits publics destinés à l’IA, elle est également mieux organisée. Le ministre des Armées (Sébastien Lecornu) a annoncé qu’il prend pour «modèle ce qui s’est fait avec l’atome dans les années 1960» pour conduire le saut technologique que représente l’intelligence artificielle [23]. Cette hyper-centralisation exercée par l’institution militaire contraste avec la dispersion des financements publics civils qui transitent par de nombreux canaux mis en place par les institutions de politique publique. Quelles en sont les conséquences? Dans un rapport publié en 2023, la Cour des Comptes observe une «absence de gouvernance ou de coordination pour l’ensemble des usages de l’IA et des infrastructures critiques associées», un «suivi insuffisant des financements associés» qui risque d’occasionner «des divergences de priorités, des difficultés de diffusion des innovations, ainsi qu’une réduction de l’efficience des investissements qui peuvent être réalisés de manière dispersée» [24]. Ce constat d’un entrelacement et cette opacité des dispositifs publics coûteux mis en place ne sont pas le fruit du hasard, mais un trait structurel du comportement de la Haute Administration (le ‘millefeuille administratif’ a de beaux jours devant lui) qui caractérise l’ensemble de la politique industrielle [25].

La défense n’est pas seulement privilégiée dans l’affectation des crédits publics destinés à l’IA, elle est également mieux organisée. Le ministre des Armées (Sébastien Lecornu) a annoncé qu’il prend pour «modèle ce qui s’est fait avec l’atome dans les années 1960» pour conduire le saut technologique que représente l’intelligence artificielle [23]. Cette hyper-centralisation exercée par l’institution militaire contraste avec la dispersion des financements publics civils qui transitent par de nombreux canaux mis en place par les institutions de politique publique. Quelles en sont les conséquences? Dans un rapport publié en 2023, la Cour des Comptes observe une «absence de gouvernance ou de coordination pour l’ensemble des usages de l’IA et des infrastructures critiques associées», un «suivi insuffisant des financements associés» qui risque d’occasionner «des divergences de priorités, des difficultés de diffusion des innovations, ainsi qu’une réduction de l’efficience des investissements qui peuvent être réalisés de manière dispersée» [24]. Ce constat d’un entrelacement et cette opacité des dispositifs publics coûteux mis en place ne sont pas le fruit du hasard, mais un trait structurel du comportement de la Haute Administration (le ‘millefeuille administratif’ a de beaux jours devant lui) qui caractérise l’ensemble de la politique industrielle [25].

Le tropisme militaire des politiques publiques en IA affaiblit la recherche publique et l’industrie civile. En effet, les performances scientifiques de la France dans le domaine de l’IA telles qu’elles sont mesurées par le nombre de publications citées [26] se sont détériorées. La France est passée de la 5e place en 2003 à la 8e en 2013 puis à la 12e place en 2023, elle est désormais cinquième en Europe derrière le Royaume-Uni, l’Allemagne, l’Italie et l’Espagne, et elle est en passe d’être rattrapée par l’Iran (données: Scimago). C’est un des effets de l’appauvrissement de la recherche publique civile organisé depuis des années que l’excellence de la recherche en mathématiques n’arrive plus à enrayer. D’ailleurs, dans ce domaine également, la situation se détériore. La France a régressé, passant du 4e rang mondial en 2013 au 7e rang en 2023, et elle est désormais dépassée par l’Inde, le Royaume-Uni et l’Italie.

L’industrie civile connaît un recul bien plus dévastateur. La qualité de la recherche publique et le soutien de beaucoup d’argent public mis sur la table par la Banque Publique d’Investissement (BPI) ont certes permis à quelques chercheurs de créer des start-up dont certaines sont des leaders mondiaux – Mistral AI étant la plus citée. En revanche les grands groupes qui captent pourtant une bonne partie du financement public de R&D font pâle figure. Thales, qui produit des armes de haute technologie, est le premier déposant de brevets en IA en France, mais, enclavé dans la défense, il n’est pas présent dans le Top 20 des entreprises européennes déposant des brevets IA (source: Questel). En fait, six décennies de politique technologique dominée par les grands programmes militaires et stratégiques ont marginalisé plusieurs secteurs industriels déterminants (électronique, informatique, machine-outil). Les ‘champions nationaux’ peuplent en nombre le cimetière des faillites: Alcatel, Alstom énergie, Areva (rebaptisé Orano en 2018). Le plus récent sinistre est celui d’ATOS, vers lequel l’argent public afflue à nouveau – comme ce fut le cas dans les décennies 1960, 1970 et 1980 pour Bull qu’ATOS a d’ailleurs racheté. Il faut en effet – et ‘quoi qu’il en coûte’ – sauver sa filiale qui produit les supercalculateurs qui forment un maillon essentiel de la dissuasion nucléaire française et qui sont indispensables pour gérer certains systèmes d’armes.

En sorte qu’en participant à la course à la militarisation de l’IA, le gouvernement français malmène la recherche publique et dégrade un peu plus le système industriel. (Article publié dans La Vie de la recherche scientifique (VRS), n° 437, avril-mai-juin 2024 – éditeur: Syndicat national des chercheurs scientifiques [SNCS-FSU], Syndicat national de l’enseignement supérieur [SNESUP-FSU])

Notes

[1] Parnas “The Real Risks of Artificial Intelligence”, Communications of the ACM, Volume 60, 10, Octobre 2017.

[2] Ces évolutions majeures sont développées dans Serfati Claude, Un monde en guerre, Textuel, avril 2024, dans le chapitre «L’intelligence artificielle, au cœur de l’ordre militaro-sécuritaire».

[3] Munyon Charles N., “Neuroethics of Non-primary Brain Computer Interface: Focus on Potential Military Applications”, Frontiers in neurosciences, 2018, 12.

[4] Hoadley Daniel S. et Lucas Nathan J., et «Artificial Intelligence and National Security», Congressionnal Research Service, 26 avril 2018. Hoadley Daniel S. et Lucas Nathan J., op. cité.

[6] https://ainowinstitute.org/publication/the-algorithmically-accelerated-killing-machine

[7] Michael Depp and Paul Scharre “Artificial Intelligence and Nuclear Stability”, 16 janvier 2024, https://warontherocks.com/2019/08/america-needs-a-dead-hand/

[8] Santopinto Federico, “L’UE, l’intelligence artificielle militaire et les armes létales autonomes », IRIS, avril 2024.

[9] The Mitre Corporation, “Perspectives on Research in Artificial Intelligence and Artificial General Intelligence Relevant to DOD,” Office of the Assistant Secretary of Defense for Research and Engineerin.g, January 2017. Voir également https://stanleycenter.org/wp-content/uploads/2020/06/TheMilitarization-ArtificialIntelligence.pdf

[10] Hoadley Daniel S. et Lucas Nathan J., et «Artificial Intelligence and National Security», Congressionnal Research Service, 26 avril 2018.

[11] https://www.aljundi.ae/en/the-file/emerging-military-technologies-trends-for-2023-beyond/1/02/2023

[12] Boulanin Vincent, Davison Neil, Goussac et Netta Carlsson Peldán, “Limits on Autonomy in Weapon Systems”, SIPRI et ICRC (International Committee of the Red Cross (Comité International de la Croix-Rouge) juin 2020, p.8 et 13.

[13] Boucher Philip, “Artificial intelligence: How does it work, why does it matter, and what can we do about it?” European Parliament Research Service (EPRS), juin 2020, p.25.

[14] Breaking Defense, 9 février 2023, https://breakingdefense.com/2023/02/dods-clarified-ai-policy-flashes-green-light-for-robotic-weapons-experts/

[15] Monomita Chakraborty, 18 mai 2021, https://www.analyticsinsight.net/pentagon-is-attempting-to-incorporate-ai-controlled-robots-into-the-us-military/

[16] Michael C. Horowitz, “When speed kills: Lethal autonomous weapon systems, deterrence and stability”, Journal of Strategic Studies, 2019, 42:6.

[17] Villani Cédric, « Les enjeux de l’IA pour la Défense de demain », Revue de défense nationale, 2019/5 (N° 820), p.23.

[18] Chiva Emmanuel, «L’intelligence artificielle: un moteur de l’innovation de défense française», Revue de défense nationale, 2019/5 (N° 820), p.36.

[19] Ministère de la Défense, «L’intelligence artificielle au service de la défense», Rapport de la Task Force IA, yeptembre 2019.

[20] https://www.info.gouv.fr/actualite/defense-la-strategie-ministerielle-sur-lintelligence-artificielle

[21] Document de référence de l’orientation de l’innovation de défense (DrOID) 2022, p.33.

[22] Document de référence de l’orientation de l’innovation de défense (Droid), 2020, p.15.

[23] Les Echos, 8 mars 2024, https://www.lesechos.fr/industrie-services/air-defense/larmee-francaise-doit-prendre-tout-de-suite-le-virage-de-lia-affirme-sebastien-lecornu-2081361

[24] Cour des Comptes, « La stratégie nationale de recherche en intelligence artificielle », avril 2023, p.36.

[25] Voir Sauviat Catherine et Serfati Claude, «Un bilan des politiques industrielles en France – Focus sur deux secteurs, l’industrie pharmaceutique et les télécoms et sur l’industrie 4.0», Rapport de l’Agence d’objectifs CFE-CGC n° 2021-2, décembre 2023, https://ires.fr/?s=sauviat+serfati&submit=

[26] Je n’engage pas ici le débat sur les limites des indicateurs bibliométriques.

Soyez le premier à commenter