«Entre 2006 et 2013, la croissance française mesurée par l’Insee, a été en moyenne 0,42 % par an, mais selon Philippe Aghion, elle se serait élevée à 0,99 % par an si le progrès technologique avait été correctement pris en compte». Tel est le résultat frappant que Les Échos viennent de mettre en exergue [1].

Lors d’un entretien sur Alternatives économiques [2], Philippe Aghion constatait que l’«accélération de l’innovation ne se traduit pas dans les chiffres de productivité». Mais il mettait cette discordance sur le compte d’un «problème de mesure» et il annonçait : «Je suis en train de travailler sur le sujet avec Peter Klenow de Stanford, pour mesurer cet effet avec plus de précision. Rendez-vous dans quelques mois». La promesse a été tenue: Philippe Aghion et Peter Klenow – auxquels se sont joints trois autres économistes – viennent de publier un document consacré à la «croissance manquante» [3] (Aghion et al. dans ce qui suit).

L’exercice reprend la logique du rapport Boskin de 1996 [4]: la production en valeur peut être décomposée en volume et en prix. On suppose que la mesure en valeur est correcte. Mais si les indices de prix ne prennent pas suffisamment en compte l’amélioration de qualité des produits liée aux innovations, alors l’inflation est surévaluée et la croissance sous-estimée. La méthode consiste donc à corriger la mesure de l’inflation, pour calculer une «vraie» inflation et donc une «vraie» mesure du volume. La différence entre la «vraie» croissance et la croissance observée est donc la «croissance manquante» (missing growth).

Devant un travail qui utilise une modélisation très complexe, une première attitude consiste comme le fait le journaliste des Échos à prendre les résultats à la lettre. Mais un tel résultat doit être soumis à la critique pour deux raisons. D’une part, il tranche avec d’autres études, par exemple celle de trois économistes de la Federal Reserve Bank de San Francisco [5]. Et surtout, l’étude s’appuie sur une maquette de l’économie, plutôt que sur un modèle. Cela veut dire, comme on cherchera à le montrer, que les valeurs des paramètres de la maquette sont choisies de manière largement arbitraire, alors même qu’ils ont un impact important sur les résultats.

A côté de la plaque

Mais avant de se lancer dans un décorticage (un peu fastidieux) de l’étude Aghion et al. qui porte sur les Etats-Unis, il n’est pas inutile d’examiner les implications des résultats obtenus pour la France tels qu’ils sont rapportés dans Les Échos. Même si on les accepte, il est troublant de constater qu’ils ne permettent pas d’effacer le ralentissement des gains de productivité, ce dont les auteurs ne semblent pas se rendre compte.

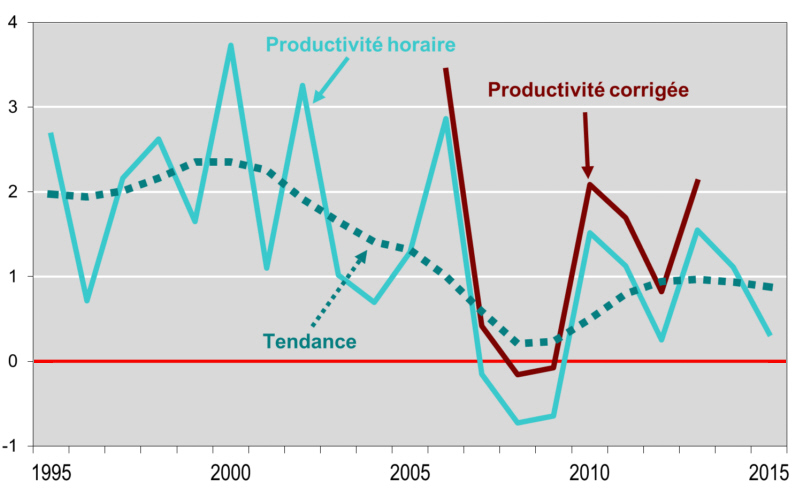

Dans son entretien à Alternatives économiques, Philippe Aghion disait «ne pas croire à ce genre de vision» mais son pari d’en proposer une autre est perdu. Ses correctifs ne changent rien au ralentissement de la productivité horaire qui fonde l’hypothèse de stagnation séculaire» à laquelle «il ne croit pas». Déplacer la courbe (et en plus sur la période 2006-2013 marquée par la crise) ne change pas la tendance générale, comme le montre le graphique ci-dessous.

Graphique 1

Un modèle ésotérique

Il faut maintenant passer au décryptage de l’étude Aghion et al. qui porte sur les Etats-Unis Cet examen doit avant tout distinguer le modèle algébrique et son identification, autrement dit son application quantifiée aux données empiriques. Dans le monde des concepts, tout est possible, mais c’est le passage au monde réel où se produit le «grand saut».

L’étude commence par présenter la structure générale de l’économie sous forme d’une fonction CES (à élasticité de substitution constante). Le produit global est composé de N entrants (intermediate inputs) qui interviennent avec une double dimension: leur quantité y est multipliée par leur «qualité» q.

Cette fonction de production pourrait, nous dit-on, être indifféremment interprétée comme «l’utilité d’un consommateur représentatif qui consomme N produits y différents de qualité q». Cette équivalence laisse perplexe: les consommateurs, que l’on sache, ne consomment pas des biens intermédiaires. Il y a donc, dès le départ, un artifice et une confusion délibérée.

Il existe déjà une abondante littérature qui explique que la production est sous-estimée parce qu’elle ne prend pas correctement en compte l’amélioration de la qualité des produits. Cette argumentation est elle-même discutable, mais elle n’a pas en tout état de cause d’équivalence du côté des entrants de la production. On peut légitimement discuter de la «qualité» d’un smartphone qui augmente avec les services qu’il rend, mais l’efficacité d’un entrant se mesure objectivement par la dépense de travail qu’il nécessite. C’est d’ailleurs ce que pose le document : «chaque bien intermédiaire est produit en équivalence exacte (one-for-one) [avec] la quantité de main-d’œuvre utilisée».

Mais on verra que ce curieux télescopage – qui consiste à importer dans le champ de la production une problématique qui n’a de sens que dans celui de la consommation – a une fonction: celle de permettre, dans la seconde étape, de justifier la quantification de l’un des paramètres essentiels du modèle.

Une calibration héroïque

En fait, le modèle théorique complet ne sert plus à grand-chose et la méthode d’estimation suit une autre piste, celle des parts de marché. Le raisonnement part du principe selon lequel une entreprise innovante va au moins conserver sa part de marché. L’indicateur clé est alors l’évolution d’une année à l’autre de la part de marché des produits pérennes (continuers): si elle baisse, cela veut dire que leur prix a augmenté plus vite que la moyenne, ce qui est la marque d’un retard d’innovation. En supposant, ce qui est fait explicitement, que le marché est concurrentiel, la croissance manquante peut alors être calculée comme la différence entre l’inflation observée et la «vraie» inflation qui se déduit de l’évolution de la part de marché des continuers. Il faut, en outre, prendre en compte le degré de substituabilité entre ces différents biens, que retrace l’élasticité de substitution représentée par sigma, un paramètre essentiel sur lequel on revient plus bas.

Dans cette approche, le niveau d’analyse est l’établissement (plant) et non l’entreprise (firm). Chaque établissement va augmenter le nombre de biens qu’il produit, mais le modèle doit supposer que ce nombre de biens est constant après un délai de 5 ans, qui correspond à la périodicité de l’enquête utilisée, le Census of Manufactures (CMF). Enfin la limitation des données fait que la part de marché n’est pas mesurée par les ventes mais à partir de l’emploi ou de la masse salariale qui figurent dans les données de la Longitudinal Business Database: «Nous utilisons cette information sur l’emploi et la masse salariale pour en déduire (infer) la dynamique des parts de marché».

On voit ici apparaître un travers courant dans ce type d’étude, à savoir l’utilisation incontrôlée de données empiriques pour quantifier des grandeurs conceptuelles avec lesquelles leur rapport n’est pas clairement établi. Dans le cas présent, le saut périlleux de cette «inférence» reste un mystère de l’analyse économique moderne.

Outre le mode de calcul des parts de marché des continuers, les résultats dépendent en fin de compte de deux paramètres clés: l’élasticité de substitution sigma et le délai d’observation k. Le paramètre k est pris égal à 5 pour une raison très pragmatique : c’est la périodicité de l’enquête. Mais il est alors nécessaire d’introduire une «hypothèse critique» (pourtant contradictoire avec le modèle) selon laquelle «le nombre de produits par établissement est constant après 5 ans». Il suffit aux auteurs de signaler que cela leur «semble être une approximation raisonnable de la réalité» pour passer à la suite.

Reste la fameuse élasticité de substitution sigma. Elle joue un rôle essentiel dans l’exercice. Si elle est élevée, la croissance manquante sera faible, voire nulle, parce que les processus innovants se substitueront aux processus périmés de manière plus rapide et étendue. Dans la spécification de base elle est prise égale à 4. On verra que les résultats sont très sensibles à ce choix, mais il faut auparavant se demander comment ce calibrage est obtenu. Il ne résulte pas d’une identification directe à partir des données empiriques: il est importé d’autres études. Ce procédé «endogamique» où les paramètres circulent d’une étude à l’autre est caractéristique de toute cette littérature.

La première étude mobilisée [6] propose une «approche unifiée de la demande et du bien-être». Après avoir développé un modèle théorique (au moins aussi compliqué que celui d’Aghion et al.), on passe à une sorte d’étude de marché qui utilise la base de données que la Nielsen Company [7] collecte sous forme de codes-barres auprès de 50’000 ménages et des plus importants réseaux de commerce de détail des Etats-Unis

L’étude, apprend-on, porte sur «une centaine de groupes de produits qui constituent les “produits emballés” (packaged goods). Les plus importants sont les boissons gazeuses, les aliments pour animaux domestiques, les produits en papier, le pain et les produits de boulangerie ainsi que le tabac. Les codes-barres spécifient les unités qui sont généralement définies selon le volume, le poids, la zone, la longueur ou l’unité, par exemple les onces liquides (fluid ounces) pour les boissons gazeuses. Nous ajustons également pour les multipacks.»

De cette masse de données, les auteurs extirpent une élasticité de substitution qui décrit le comportement des consommateurs. Ces derniers vont remplir différemment leurs caddies en fonction des prix relatifs : ils achèteront par exemple plus de Coca ou de cigarettes si les aliments pour leurs chats ou leurs chiens deviennent moins chers. C’est passionnant, mais quel rapport avec la recherche de la «croissance manquante»? On retrouve ici l’amalgame saugrenu rappelé plus haut entre l’analyse de la production et celle de la consommation. Comment oser transposer ainsi un paramètre calculé sur les relevés de Walmart à l’ensemble de l’économie des Etats-Unis?

Dans la seconde étude [8], il est apparemment question de firmes et donc de production. Cependant la base empirique est encore une fois celle de la Nielsen Company, autrement dit un big data de codes-barres, et les auteurs sont les mêmes. Cet effet de renforcement est lui aussi typique mais l’importation des résultats de ces deux études dans celle de Aghion et al. n’est décidément pas légitime.

Des résultats élastiques

Aghion et al. présentent ensuite leurs estimations chiffrées et leur sensibilité au calibrage des paramètres essentiels. Le graphique ci-dessous illustre le résultat essentiel: la croissance manquante varie entre 0,4 % et 0,7 % par an selon les sous-périodes, la moyenne étant de 0,56 % sur l’ensemble de la période 1983-2013 analysée.

Graphique 2

Mais ces résultats sont très sensibles au paramétrage. Si on prend k=0 au lieu de k=5, autrement dit si on réduit à zéro le temps nécessaire en années pour que se matérialise l’impact de l’innovation sur la part de marché, la croissance manquante est divisée par trois (0,20 % au lieu de 0,56 %) sur l’ensemble de la période et est à peu près nulle (0,07 %) entre 2006 et 2013. Les auteurs affirment que le choix de 5 ans est «raisonnable» mais oublient de dire que les données rendent impossible un choix intermédiaire.

Selon un procédé décidément bien rodé, ils renvoient à une autre étude [9] qui ne saurait en rien valider le choix des 5 ans, puisque son auteur raisonne a priori sur une tranche d’âge de 0 à 5 ans. Et pour boucler provisoirement cette valse des articles typique du champ de la recherche académique, cette même étude s’appuie à son tour sur une autre [10] dont les auteurs constataient que «les nouveaux entrants et les établissements récents ont une productivité totale des facteurs légèrement supérieure à celle des établissements pérennes et significativement supérieure à celle des établissements sortants». Autrement dit, le gain en productivité des nouveaux entrants n’est que «légèrement» (slightly) positif, ce qui ne va évidemment pas dans le sens des évaluations d’Aghion et al.

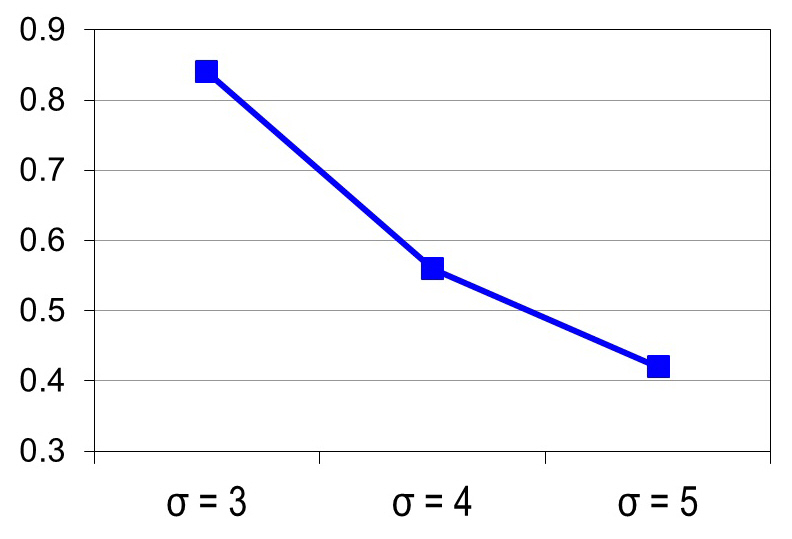

Le paramétrage de la fameuse élasticité de substitution sigma conduit elle aussi à une grande variabilité des résultats comme le montre le graphique ci-dessous.

Graphique 3

Comme on l’a vu, la croissance manquante varie en sens inverse de l’élasticité de substitution sigma. Compte tenu de l’imprécision présidant à son choix, on pourrait imaginer des cas extrêmes. Si par exemple cette élasticité était égale à l’unité (dans ce cas la fonction de production «CES» devient une «Cobb-Douglas»), alors on pourrait en extrapolant la courbe arriver à des estimations de la croissance manquante totalement extravagantes. Il suffit en effet de passer de sigma =4 à sigma =3 pour augmenter de moitié la croissance manquante (de 0,56 % par an à 0,84 %). En sens inverse, une élasticité plus élevée aurait pour effet de réduire à peu de chose cette croissance manquante.

Scientificité ou dégénérescence de l’économie politique?

Le discours économique dominant est produit selon une chaîne de production qui mène des contributions ésotériques comme celle d’Aghion et al. à des articles de vulgarisation comme celui des Échos cité plus haut. Il ne reste plus qu’à traduire la version populaire en arguments permettant de justifier les politiques menées par l’invocation des «études qui prouvent». Le désir de «faire science» des économistes s’articule avec le besoin de légitimation des politiques. Les premiers invoquent l’objectivité scientifique et récusent tout procès de biais idéologique, ce qui permet aux politiques de se présenter comme les simples exécutants des vérités produites par cette science.

La remise en cause de la doxa dominante implique donc de remonter en amont de cette chaîne de production. Mais le risque est alors que cette critique apparaisse comme un débat technique réservé à des spécialistes qui, de surcroît, se déroule dans un champ très polarisé où les intervenants ne s’affrontent pas à armes égales. Ce rapport de forces peut d’ailleurs s’analyser de manière très matérialiste à travers l’examen des effectifs, des budgets et des procédures de filtrage des recrutements. L’économie dominante fonctionne comme un «appareil idéologique» qui combine l’idéologie scientifique et les dispositifs institutionnels.

L’un des maillons faibles (au moins potentiellement) se situe dans le saut périlleux qui fait passer du modèle ultra-théorique à son identification empirique. Le document d’Aghion et al., parmi beaucoup d’autres, illustre cette discontinuité. Dans le monde de l’ultra-théorie, on peut introduire des notions évanescentes comme la probabilité et le taux d’apparition des innovations: il suffit de lettres grecques. Et pour traiter de l’énorme question de la «qualité» des biens, il suffit de multiplier la quantité de ce bien par sa qualité, notée q. Après tout, cette formalisation n’a rien de répréhensible s’il s’agit d’un détour de production débouchant vers une forme «estimable», autrement dit susceptible d’être confrontée aux données empiriques.

Mais le plus souvent, il n’existe aucune solution de continuité et il faut avoir recours à des artifices ou à de supposés proxies qui n’ont qu’un rapport éloigné avec le modèle théorique initial. C’est particulièrement évident chez Aghion et al. : le procédé consistant à regarder les parts de marché des produits pérennes est une piste intéressante, mais il n’a pas grand-chose à voir avec le modèle initial. Il est même probable que ce type d’études est construit à l’envers : le point de départ est la partie empirique pour laquelle on fabrique un modèle dont elle serait l’application.

En tout cas, il existe clairement une dialectique entre ces deux volets. Là encore, Aghion et al. fournissent un bon exemple. L’assimilation incohérente entre fonction de production et utilité du consommateur qui figure au début du document n’est là que pour justifier le fait d’aller chercher la «bonne» valeur de l’élasticité sigma – un paramètre clé de l’estimation – dans une autre étude qui porte sur un échantillon de codes-barres.

Ces à-peu-près et ces n’importe quoi méthodologiques ne sont que rarement dénoncés. Les raisons se trouvent dans la structure du champ. Pour commencer, les critiques ne font pas le poids par rapport aux gros bataillons des universités, des banques, des institutions, etc. et leurs lieux d’expression sont rares et stigmatisés par les défenseurs de l’ordre académique. Ces positions dominantes sont renforcées par les stratégies des économistes, des revues et des centres de recherche. Il y a entre eux une forte concurrence, mais elle se déroule dans les limites d’une connivence fondamentale qui consiste à ne jamais remettre en cause les revendications de scientificité. Les polémiques porteront souvent sur la qualité des tests économétriques, mais à peu près jamais sur l’adéquation des modèles utilisés à la réalité. Cette conjuration des ânes savants délimite les frontières hermétiques de la «science économique».

De temps à autre, un grand nom plus lucide jette un pavé dans la mare, mais celle-ci retrouve rapidement sa quiétude. Le dernier en date est Paul Romer, l’inventeur de la théorie de la «croissance endogène», aujourd’hui économiste en chef à la Banque mondiale. Voilà ce qu’il écrivait, il y a peu [11], et qui servira de conclusion à cette contribution :

«Depuis plus de trois décennies, la macroéconomie a reculé. Le traitement de l’identification n’est pas plus assuré aujourd’hui qu’au début des années 1970 mais il échappe à la discussion parce qu’il est encore beaucoup plus opaque. Les théoriciens de la macroéconomie rejettent de simples faits en feignant une ignorance obtuse à propos d’affirmations élémentaires, par exemple : “une politique monétaire restrictive peut entraîner une récession”. Leurs modèles attribuent les fluctuations des variables globales à des forces causales imaginaires qui ne dépendent du comportement d’aucun individu. Un parallèle avec la théorie des cordes de la physique suggère une manière de faire science condamnée à un échec général. Cela se produit quand le respect à l’égard de maîtres hautement estimés se transforme en une déférence à l’autorité qui expulse le fait objectif comme déterminant ultime de la vérité scientifique.» (Juillet 2017)

Notes

[1] Guillaume de Calignon, « Pourquoi la croissance est sous-estimée », Les Échos, 23 juin 2017. L’article fait référence à un travail similaire sur la France présenté à l’AFSE, non disponible lors de la rédaction de cette contribution.

[2] Christian Chavagneux, « Rencontre avec Philippe Aghion », Alternatives économiques, 1er octobre 2015.

[3] Philippe Aghion, Antonin Bergeaud, Timo Boppart, Peter J. Klenow, Huiyu Li, « Missing Growth from Creative Destruction », June 2017.

[4] Les auteurs du rapport ont présenté leurs résultats dans : Michael J. Boskin, Ellen R. Dulberger, Robert J. Gordon, Zvi Griliches, Dale W. Jorgenson, « Consumer Prices, the Consumer Price Index, and the Cost of Living », Journal of Economic Perspectives, vol.12, n° 1, Winter 1998.

[5] David Byrne, John G. Fernald, Marshall Reinsdorf, « Does Growing Mismeasurement Explain Disappointing Growth? », FRBSF Economic Letter, February 13, 2017.

[6] Stephen J. Redding, David E. Weinstein, « A Unified Approach to Estimating Demand and Welfare », NBER, March 2017.

[7] Nielsen Datasets at the Kilts Center for Marketing

[8] Colin J. Hottman, Stephen J. Redding, David E. Weinstein, « Quantifying the Sources of Firm Heterogeneity », The Quarterly Journal of Economics, 2016, vol.131, n° 3.

[9] John Haltiwanger, « Job Creation, Job Destruction, and Productivity Growth: The Role of Young Businesses », Annual Review of Economics, vol.7, 2015.

[10] Lucia Foster, John Haltiwanger, Chad Syverson, « Reallocation, firm turnover, and efficiency: selection on productivity or profitability? », American Economic Review, vol. 98, no. 1, March 2008.

[11] Paul Romer, « The Trouble with Macroeconomics », 14th September, 2016.

Soyez le premier à commenter